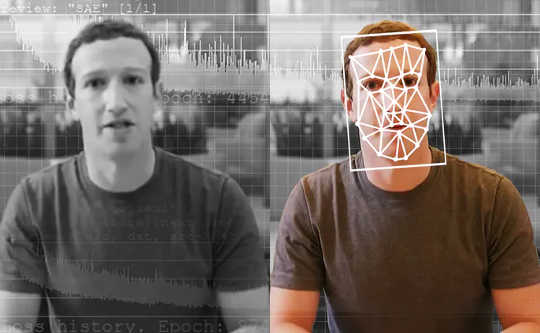

Pengesan berkuasa AI adalah alat terbaik untuk melihat video palsu buatan AI. The Washington Post melalui Getty Images

Seorang wartawan penyiasat menerima video dari pemberi maklumat tanpa nama. Ini menunjukkan calon presiden mengakui kegiatan haram. Tetapi adakah video ini nyata? Sekiranya demikian, itu akan menjadi berita besar - rangkuman seumur hidup - dan sepenuhnya dapat membalikkan pilihan raya yang akan datang. Tetapi wartawan menjalankan video melalui alat khusus, yang mengatakan kepadanya bahawa video itu bukan seperti yang kelihatannya. Sebenarnya, ia adalah "deepfake, "Video yang dibuat menggunakan kecerdasan buatan dengan pembelajaran mendalam.

Wartawan di seluruh dunia tidak lama lagi dapat menggunakan alat seperti ini. Dalam beberapa tahun, alat seperti ini bahkan dapat digunakan oleh semua orang untuk membasmi kandungan palsu dalam suapan media sosial mereka.

As penyelidik yang telah mengkaji pengesanan deepfake dan mengembangkan alat untuk wartawan, kami melihat masa depan untuk alat ini. Namun, mereka tidak akan menyelesaikan semua masalah kita, dan mereka akan menjadi salah satu bahagian senjata dalam memerangi maklumat yang lebih luas.

Masalah dengan deepfakes

Kebanyakan orang tahu bahawa anda tidak boleh mempercayai semua yang anda lihat. Selama beberapa dekad terakhir, pengguna berita yang cerdas telah terbiasa melihat gambar dimanipulasi dengan perisian penyuntingan foto. Video, bagaimanapun, adalah kisah lain. Para pengarah Hollywood boleh menghabiskan berjuta-juta dolar untuk kesan khas untuk membuat pemandangan yang realistik. Tetapi menggunakan deepfakes, amatur dengan peralatan komputer beberapa ribu dolar dan beberapa minggu untuk menghabiskan dapat membuat sesuatu yang hampir sama dengan kehidupan.

Deepfakes memungkinkan untuk memasukkan orang ke dalam adegan filem yang tidak pernah mereka saksikan - fikir Tom Cruise bermain Iron Man - yang membuat video menghiburkan. Malangnya, ia juga memungkinkan untuk membuat pornografi tanpa kebenaran orang yang digambarkan. Setakat ini, orang-orang itu, hampir semua wanita, adalah mangsa terbesar apabila teknologi deepfake disalahgunakan.

Deepfakes juga dapat digunakan untuk membuat video pemimpin politik yang mengatakan perkara yang tidak pernah mereka katakan. Parti Sosialis Belgia melancarkan video nondeepfake berkualiti rendah tetapi masih palsu Presiden Trump menghina Belgium, yang mendapat reaksi yang cukup untuk menunjukkan potensi risiko deepfakes berkualiti tinggi.

{vembed Y = poSd2CyDpyA}

University of California, Berkeley's Hany Farid menerangkan bagaimana deepfakes dibuat.

Mungkin paling menakutkan dari semua, mereka boleh digunakan untuk membuat keraguan mengenai kandungan video sebenar, dengan menunjukkan bahawa mereka boleh menjadi deepfakes.

Memandangkan risiko ini, sangat mustahak untuk dapat mengesan deepfake dan melabelnya dengan jelas. Ini akan memastikan bahawa video palsu tidak memperbodohkan orang ramai, dan bahawa video sebenar dapat diterima sebagai sahih.

Mengesan palsu

Pengesanan deepfake sebagai bidang penyelidikan telah dimulakan sedikit tiga tahun lalu. Kerja awal difokuskan pada mengesan masalah yang dapat dilihat dalam video, seperti deepfakes yang tidak berkelip. Dengan masa, bagaimanapun, palsu semakin baik meniru video sebenar dan menjadi sukar untuk dilihat untuk kedua-dua orang dan alat pengesanan.

Terdapat dua kategori utama penyelidikan pengesanan deepfake. Yang pertama melibatkan melihat tingkah laku orang dalam video. Katakan anda mempunyai banyak video seseorang yang terkenal, seperti Presiden Obama. Kecerdasan buatan boleh menggunakan video ini untuk mempelajari coraknya, dari isyarat tangannya hingga berhenti dalam ucapan. Ia boleh perhatikan orang yang mendalam dan perhatikan di mana ia tidak sesuai dengan corak tersebut. Pendekatan ini mempunyai kelebihan mungkin berfungsi walaupun kualiti video itu sendiri pada dasarnya sempurna.

{vembed Y = gsv1OsCEad0}

Aaron Lawson SRI International menerangkan satu pendekatan untuk mengesan deepfake.

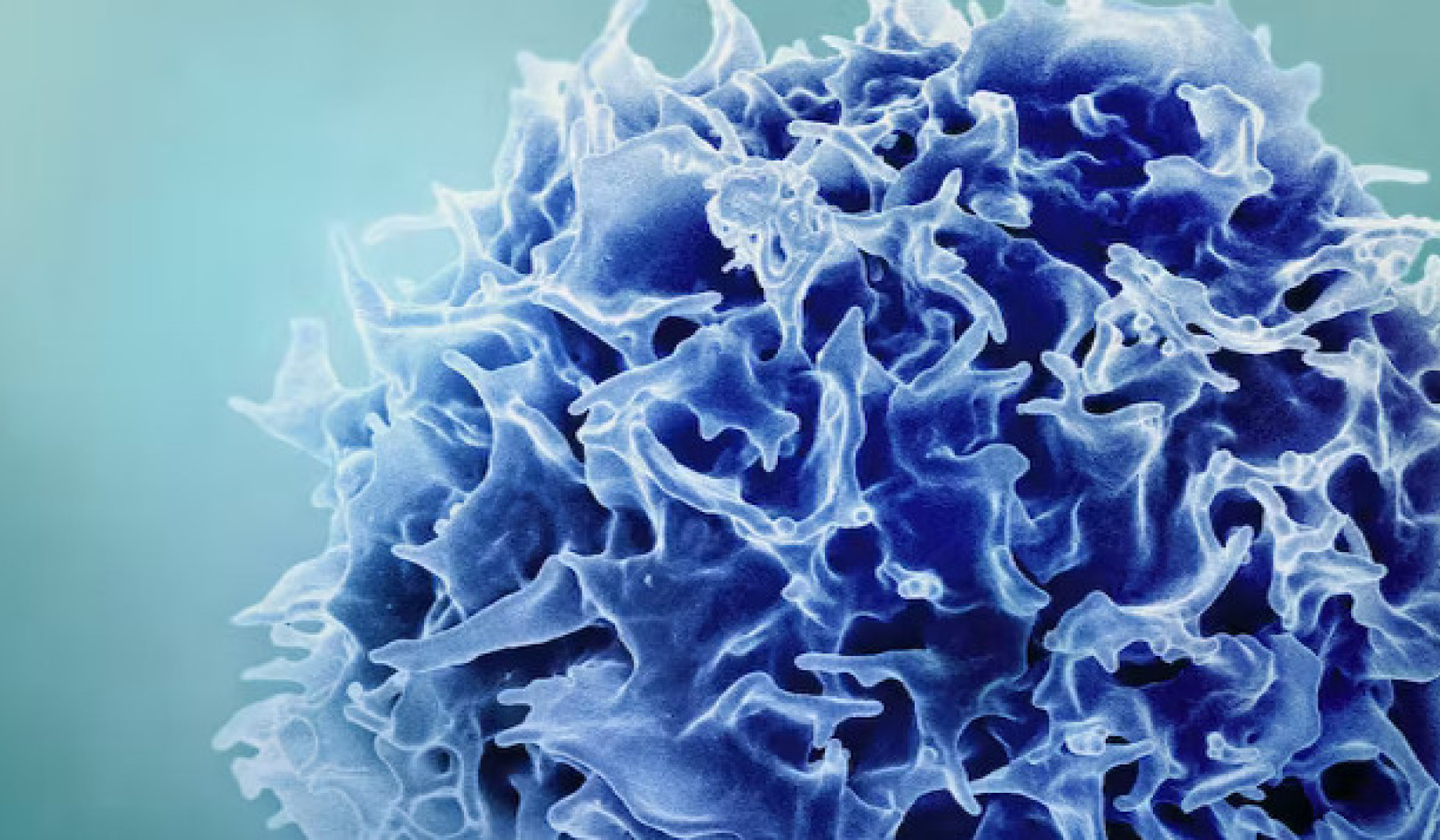

Penyelidik lain, termasuk pasukan kami, telah diberi tumpuan perbezaan Bahawa semua deepfakes ada berbanding dengan video sebenar. Video deepfake sering dibuat dengan menggabungkan bingkai yang dihasilkan secara individu untuk membentuk video. Dengan mengambil kira itu, kaedah pasukan kami mengekstrak data penting dari wajah dalam bingkai individu video dan kemudian mengesannya melalui set bingkai serentak. Ini membolehkan kita mengesan ketidakkonsistenan dalam aliran maklumat dari satu bingkai ke bingkai yang lain. Kami juga menggunakan pendekatan serupa untuk sistem pengesanan audio palsu kami.

Perincian halus ini sukar dilihat oleh orang, tetapi menunjukkan betapa mendalamnya kepalsuan belum sempurna. Pengesan seperti ini boleh berfungsi untuk mana-mana orang, bukan hanya beberapa pemimpin dunia. Pada akhirnya, mungkin diperlukan kedua-dua jenis alat pengesan deepfake.

Sistem pengesanan terkini menunjukkan prestasi yang sangat baik pada video yang dikumpulkan secara khusus untuk menilai alat. Malangnya, walaupun model terbaik ada kurang baik pada video yang terdapat dalam talian. Memperbaiki alat ini agar lebih mantap dan berguna adalah langkah seterusnya.

Siapa yang harus menggunakan alat pengesan deepfake?

Sebaik-baiknya, alat pengesahan deepfake harus tersedia untuk semua orang. Walau bagaimanapun, teknologi ini berada di peringkat awal pembangunan. Penyelidik perlu meningkatkan alat dan melindunginya daripada penggodam sebelum melepaskannya secara meluas.

Namun, pada masa yang sama, alat untuk membuat deepfakes tersedia untuk sesiapa sahaja yang ingin memperbodohkan orang ramai. Duduk di luar bukanlah pilihan. Bagi pasukan kami, keseimbangan yang tepat adalah bekerja dengan wartawan, kerana mereka adalah barisan pertahanan pertama menentang penyebaran maklumat yang salah.

Sebelum menerbitkan cerita, wartawan perlu mengesahkan maklumat tersebut. Mereka telah mencuba kaedah yang benar, seperti memeriksa dengan sumber dan meminta lebih daripada satu orang untuk mengesahkan fakta utama. Oleh itu, dengan meletakkan alat itu ke tangan mereka, kami memberi mereka lebih banyak maklumat, dan kami tahu bahawa mereka tidak akan bergantung pada teknologi sahaja, memandangkan ia boleh membuat kesilapan.

Bolehkah pengesan memenangi perlumbaan senjata?

Adalah menggembirakan untuk melihat pasukan dari Facebook and microsoft melabur dalam teknologi untuk memahami dan mengesan mendalam. Bidang ini memerlukan lebih banyak penyelidikan untuk mengikuti perkembangan teknologi deepfake.

Wartawan dan platform media sosial juga perlu memikirkan cara terbaik untuk memberi amaran kepada orang ramai mengenai kejadian mendalam ketika mereka dikesan. Penyelidikan telah menunjukkan bahawa orang ingat pembohongan, tetapi bukan fakta bahawa itu adalah dusta. Adakah perkara yang sama berlaku untuk video palsu? Cukup dengan meletakkan "Deepfake" dalam tajuk mungkin tidak cukup untuk mengatasi beberapa jenis maklumat.

Deepfakes ada di sini untuk menginap. Menguruskan maklumat dan melindungi orang ramai akan menjadi lebih mencabar daripada sebelumnya kerana kecerdasan buatan semakin kuat. Kami adalah sebahagian daripada komuniti penyelidikan yang sedang berkembang yang menghadapi ancaman ini, di mana pengesanan hanyalah langkah pertama.![]()

Mengenai Pengarang

John Sohrawardi, Pelajar Doktor dalam Sains Komputer dan Maklumat, Rochester Institute of Technology dan Matthew Wright, Profesor Keselamatan Komputer, Rochester Institute of Technology

Artikel ini diterbitkan semula daripada Perbualan di bawah lesen Creative Commons. Membaca asal artikel.